对于AR/VR,如何在3D空间中与虚拟对象进行交互是一个问题。在名为“Selecting virtual objects in a three-dimensional space”的专利申请中,Maigc Leap就介绍了一种在3D空间中选择虚拟对象的方法。具体来说,发明主要关于一种根据可交互对象的特性来选择合适输入模式,从而实现精确选择的方法。

例如,当可交互对象是尺寸足够大的用户界面平面时,可穿戴系统可以允许用户使用头部控制来选择对象,亦即根据用户头部移动来控制光标选择。当可交互对象是尺寸较小并需要高精度确认的虚拟对象时,可穿戴系统可以切换至手部控制选项,亦即可以根据用户手指的精细选择来控制光标移动。

在一个实施例中,可穿戴系统可以向目标可交互对象分配焦点指示符,使得用户可以更容易地感知目标可交互物体。例如,焦点指示器可以包括光晕、颜色、感知的大小或深度变化(例如当选择时令目标对象看起来更接近和/或更大),或者吸引用户注意力的其他视觉效果。

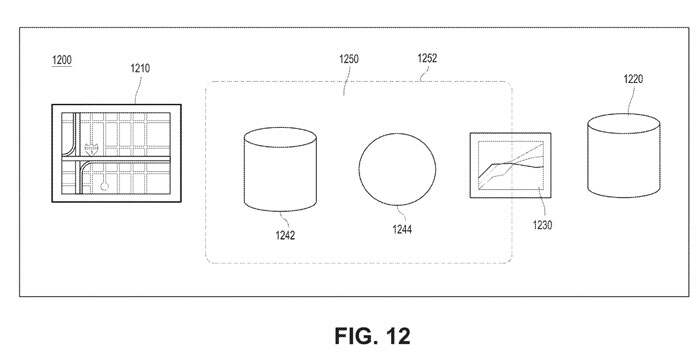

参考图12,用户可以通过可穿戴系统与1200内的可交互对象交互,特别是与视场1250内的可交互式对象交互。例如,虚拟对象1230可以是股票相关图表。通过选择虚拟对象1230,用户可以与虚拟对象12300交互并获得股票报价、购买或出售股票选项、公司详细信息等。为了执行所述交互,可穿戴系统可以显示与虚拟对象相关联的菜单、工具栏等,从而允许用户执行各种动作,比如说选择动作。

在启动选择事件时,AR系统可以将焦点指示符分配给设备视场中的目标可交互对象。例如在图12中,AR系统可以将焦点指示符分配给对象1244,因为它最接近设备视场的中点。

在选择事件期间,用户可以使用各种手势来改变目标可交互对象。例如在图12中,用户可以在向左滑动,这可以使AR系统将目标可交互对象从对象1244改变为对象1230。AR系统同时可以相应地将可见焦点指示器从对象1244传送到对象1230。

手势可以允许AR系统更新设备视场中的可选对象列表。例如在图12中,当用户向右滑动时,AR系统可以将对象1210移动到用户视场中,并将对象1230移出用户视场。AR系统同时可以基于新的可选择对象组来更新目标可交互对象。例如,在对象1210移动到视场中之后,系统可以将目标可交互对象从对象1244改变为对象1242。

用户可以使用专利描述的头部控制或手部控制来确认对目标可交互对象的选择。用户确认目标难处理对象的选择的动作可以是与用于启动选择事件的动作相同或不同的动作。当用户确认选择时,AR系统可以改变焦点指示器,例如,通过改变焦点指示器的颜色、亮度或形状。

一旦选择事件启动,可穿戴系统就可以“锁定”用户的视场,使得可穿戴系统停止更新用户视场内的可选择对象组。选择事件可以通过用户输入或通过与可穿戴系统的其他交互来终止。

使用手势在3D空间中选择虚拟对象

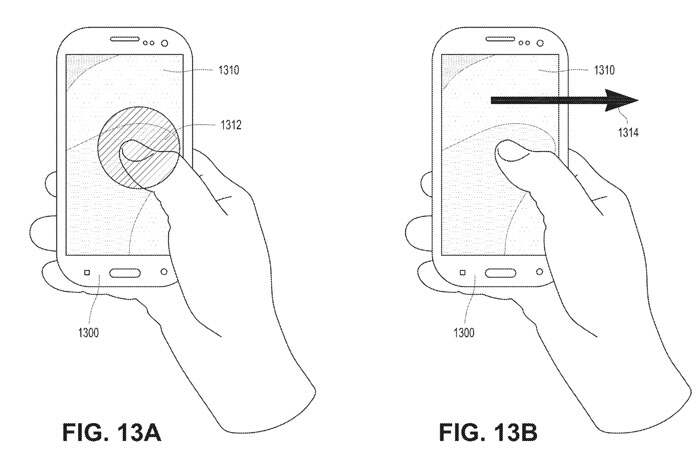

用户可以通过致动用户输入设备来瞄准并选择可交互对象。图13A示出了在用户输入设备1300的触控屏1310使用触控手势选择可交互对象。

触控手势可以触发可穿戴系统将焦点指示符分配给用户视场内的目标可交互对象。触控手势同时可以致使可穿戴系统单独或组合地发起选择事件、发起交互事件、终止选择事件、终止交互事件、确认对目标可交互对象的选择等。

图13B是在用户输入设备用手势过滤可选择对象的示例。用户可以沿着用户输入设备1300的路径滑动。如图13B中的箭头1314所示,用户可以在触控屏1310沿着向右的路径滑动。

滑动手势可以令可穿戴系统将可见焦点指示器从一个对象移动到另一个对象。参考图12中所示的示例,当用户向右滑动(如图13B中的示例所示)时,AR系统可以将焦点指示器从对象1244传送到对象1242。滑动手势可以使AR系统更新用户视场内的可选对象的列表。例如,当用户向右滑动时,AR系统可以将对象1210移动到用户的视场中,同时将对象1230移出用户的视场。接收可见焦点指示符的对象可以相应地更新(例如从对象1244到1242)。

使用头部姿势在3D空间中选择虚拟对象

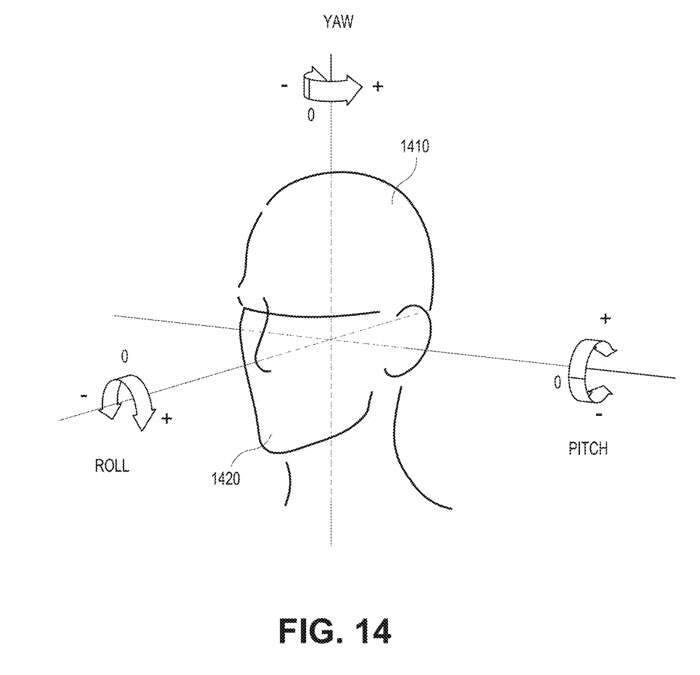

图14是用于头部姿势的坐标系的示例。头部1410可以具有多个自由度。随着头部1410朝向不同方向移动,头部姿势将相对于自然静止方向1420改变。图14中的坐标系示出了三个角自由度,并可用于测量相对于头部的自然静止状态1420的头部姿态。

如图14所示,头部1410可以向前和向后倾斜、向左和向右转动以及左右倾斜。可穿戴系统可以使用各种传感器来确定用户的头部姿势。

可穿戴系统可以基于选择事件期间头部姿势的改变来确定和更新哪个对象成为目标可交互对象。例如参考图12,当用户可以向左转动头部1410时,目标可交互对象可以从对象1244更新到其相邻对象,例如对象1230。可穿戴系统可以将焦点指示符从对象1244传送到对象1230以反映所述更新。

可穿戴系统同时可以基于头部姿势的改变来更新用户视场中的可选择对象的列表。例如,用户可以向右转动头部1410,这可以使可穿戴系统将对象1230移出用户的视场,并将对象1210移入用户的视场。

根据情景自动选择手势控制/头部姿势控制,或者推荐用户最佳方案

可穿戴系统可以基于情景信息自动选择或推荐用户交互的模式。情景信息可以包括对象的类型、对象的布局、用户的特征或用户与环境对象的当前交互等等。

例如,在光线投射期间,可穿戴系统可以检测到用户正在注视彼此靠近的多个虚拟对象。可穿戴系统可以计算用户视场中虚拟对象的密度。当密度超过某个阈值时,可穿戴系统可以建议用户切换用户交互模式。

例如,当密度超过某个阈值并表明对象彼此非常接近时,可穿戴系统可以将用户交互模式从头部姿势切换到手势,以便允许用户与对象进行更精确的交互。

作为另一个示例,当密度下降到某个阈值以下并表明对象彼此远离时,可穿戴系统可以将用户交互模式从手势切换到头部姿势。

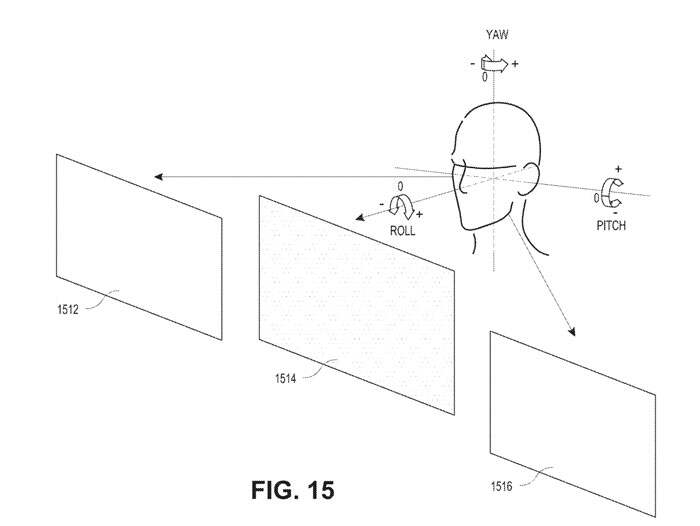

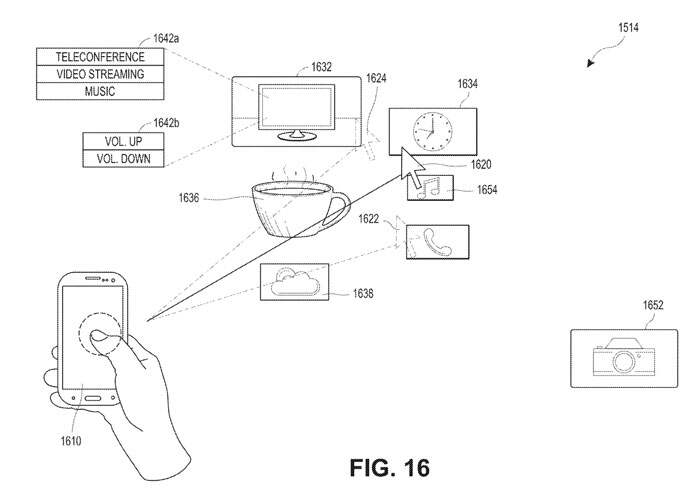

图15和图16提供了基于情景信息改变用户交互模式的示例。图15示出了与具有头部姿势的可交互对象交互的示例。图16示出了用手势与可交互对象交互的示例。

在图15中,虚拟用户界面1512、1514和1516可以是平面对象,其包括虚拟用户界面平面内的其他虚拟对象(1D、2D或3D)。虚拟用户界面1512、1514和1516具有大的尺寸,并且不密集地彼此相隔。结果,可穿戴系统可以确定头部移动可以是用户交互的最佳模式,因为用户不必大幅移动距离以选择虚拟用户界面。

可穿戴系统可以使用光线投射技术来识别用户当前正在查看虚拟用户界面1514。用户可以在虚拟用户界面1514发起选择事件以与用户界面1514中的对象交互。

如图16所示,虚拟用户界面1514可以包括多个虚拟对象,例如,虚拟电视屏幕1632、虚拟咖啡杯1636、虚拟时钟1634、相机应用1652、天气应用1638和音乐应用等。

在图16中,可穿戴系统可以确定虚拟电视 1632、虚拟时钟1634、虚拟咖啡杯1636和天气应用1638之间的相对位置。由于这四个物体彼此接近,当可穿戴系统确定用户的当前位置在位置1620时,可穿戴系统可以向用户呈现他是否想要从头部姿势切换到手势控制的选项,或者自动切换成手势控制,以便用户进行更精确的选择。

名为“Selecting virtual objects in a three-dimensional space”的Magic Leap专利申请最初在2022年11月提交,并在日前由美国专利商标局公布。

产品与服务

产品与服务

联系站长

联系站长

关于我们

关于我们