交互感知是机器人学的重要内容。视觉可以用于追踪多接触交互的对象,但这种交互可能会阻碍视觉追踪。特别是,末端效应器对象的相对定位对于多接触策略至关重要。另外,视觉通常会受到对象透明度、镜面反射度和较差场景照明的影响。有了基于高维视觉的触觉传感器,我们有了一个探知局部对象交互的窗口。然而,尽管来自这种传感器的触觉图像可以捕捉局部表面几何结构,但它们缺乏相对姿态追踪所需的全局情景。

针对这个问题,由卡内基梅隆大学和Meta AI团队组成的研究人员提出了MidasTouch。这是一个在线触觉感知系统,可追踪基于视觉的触摸传感器在已知物体上滑动的姿势分布。

以一个简单的马克杯为例:它由弯曲的杯身、平坦的底座和圆形的把手组成。如果没有全局背景,仅仅一次接触无法明确具体的位置。感知到的边缘可以位于任何位置。这种可能性分布分布在物体表面,它不是单峰分布。但是,长时间范围内的交互可以消除歧义。团队将其作为移动机器人蒙特卡罗滤波的模拟,但将其应用于物体的表面流形。正如移动机器人可以访问详细的平面图、里程计和摄像头一样,操纵者同样可以访问对象网格、末端效应器姿势和基于视觉的触摸。

这适用于具有已知对象模型的环境,如家庭、仓库和工厂,而大规模扫描对象数据集进一步促进了这一点。尽管来自视觉的先验可以引导系统,但它们不是全局估计的先决条件。除了开源的MidasTouch,团队同时发布了一个全面的真实世界和模拟数据集,涵盖了标准YCB对象之间的滑动交互。

对于沿已知物体表面动态滑动的基于视觉的触觉传感器,团队的目标是追踪6D传感器姿态的分布。这种姿势情景对于下游规划和控制有用,例如操纵机器人手中的物体。传感器固定在机器人手指之上,你可以访问末端执行器姿势,但其在物体表面上的相对位置和方向未知。在每个时间步t,测量是一个触觉图像,以及机器人参考系中的噪点传感器姿态。

为了简单起见,假设物体静止,滑动是一个连续的接触交互。物体的尺寸远大于传感器的接触面积。

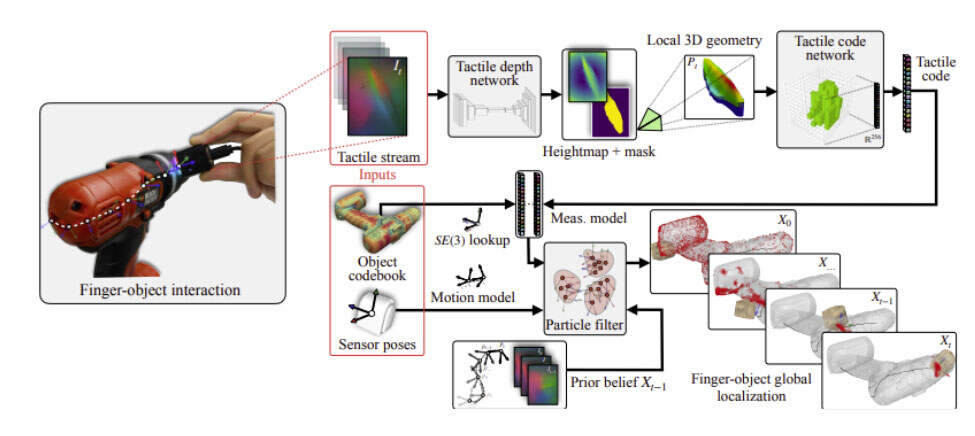

MidasTouch包括三个不同的模块,如图1所示:触觉深度网络TDN、触觉代码网络TCN和粒子滤波器。在high level,TDN首先通过学习的观察模型将触觉图像It转换为其局部3D几何Pt。然后,TCN通过稀疏3D卷积网络将3D信息压缩成触觉代码Et。最后,下游粒子滤波器在其测量模型中使用学习代码,并输出随时间演变的传感器姿态分布。在这项研究中,研究人员在测试中使用了10个具有不同几何形状的YCB对象。触觉深度网络TDN:TDN学习逆传感器模型,以从触觉图像中恢复局部3D几何结构。团队调整了完全卷积残差网络,并以有监督的方式对其进行训练,从而根据触觉图像预测局部高度图。 触觉代码网络(TCN):这个网络将局部几何的大型无序点云归纳为低维嵌入空间或代码。如果两个传感器测量值在位姿空间附近,它们观察相似的几何结构,所以它们的代码同样将在嵌入空间附近。然而,反过来并不一定正确:从立方体的两个相对角进行的测量可能具有相似的代码,但它们对应的传感器姿态不同。这是触觉定位的固有挑战。对于这项研究,获得这种分布的最可能模式已经足够,因为下游粒子过滤器可以在时间上消除它们的歧义。 粒子滤波器:粒子过滤器近似传感器姿势的后验分布。这种任意分布不是单峰高斯分布,而是捕捉全局定位的多模态。研究人员基于触觉图像流和噪点传感器姿态传播后验分布,模拟传统粒子滤波器,但使用学习的测量模型。团队发现,即使在非常缺乏信息的先验下,多模态滤波器都可以删掉假设并收敛到正确的假设。

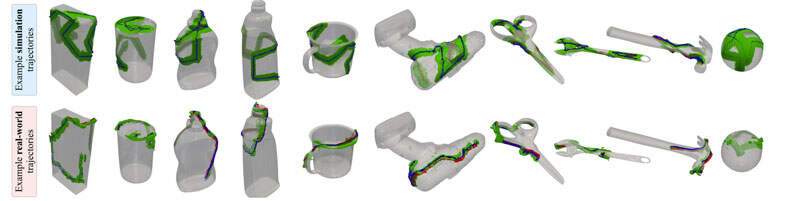

为了评估MidasTouch,并在触觉感知方面展开进一步研究,团队同时介绍了YCB数据库。它由针对10个YCB对象的机器人手指滑动交互组成。研究人员设想这将有助于触觉定位、映射、对象理解和学习动力学模型。

上图显示了三个代表性轨迹的定性结果。在每个时间步可视化姿态分布,并绘制相对于ground truth姿态的平均粒子RMSE。可以看到,在滑动交互方面,最可能的姿势假设趋同。

总的来说,团队演示了来自姿势触觉图像的机械人手指对象全局定位。这个在线方法输出物体表面上的姿态分布,当传感器穿过突出的表面几何结构时,姿态分布随时间收敛。系统从局部3D几何中学习触觉嵌入,并使用非参数粒子滤波器消除它们的歧义。实验证明,将学习的触觉感知与蒙特卡罗方法相结合来解决分布模糊可以实现出色的效果。

当然,团队坦诚,当前公式仅限于相对于固定姿势对象的移动传感器(反之亦然)。在未来的研究中,他们希望通过视觉测量和/或手部局部追踪来将动态对象纳入至运动模型之中。

产品与服务

产品与服务

联系站长

联系站长

关于我们

关于我们